F値 (評価指標)

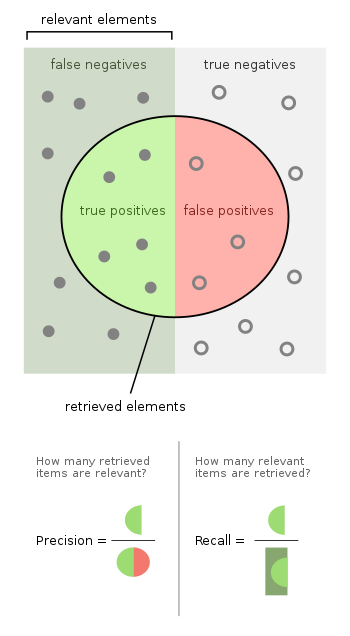

F値(F尺度とも、英: F-measure、F-score)は、二項分類の統計解析において精度を測る指標の一つである。F値は適合率と再現率から計算される。適合率とは陽性と予測したもののうち(この中には正しく予測できていないものも含まれる)実際に正しく予測できたものの割合で、再現率は全ての陽性のうち実際に陽性であると予測できたものの割合である。適合率は陽性的中率(Positive predict value、PPV)とも、再現率は感度 (sensitivity) と呼ばれることもある。

F1 Score(F1)は適合率と再現率の調和平均で計算される。より一般的なF値も考えることができて、重み付けF値 (Weighted F-score) は適合率または再現率に何らかの重みをかけた上で調和平均をとって算出する。

F値が取りうる最大値は1.0であり、これは適合率と再現率がともに1.0 (=100%) の場合である。逆にF値がとりうる最小値は0で、このとき適合率と再現率の少なくともいずれかが0である。

言葉の由来 編集

F値 (F Score) という名前は、第4回メッセージ理解会議(MUC-4, 1992)で紹介されたとき、Van Rijsbergen 氏の著書に記載されていた別のF関数にちなんで名付けられたとされている[1]。

定義 編集

従来のF値またはバランスF値(F1Score)[訳語疑問点]は、適合率と再現率との調和平均である。

編集

F1 Scoreは、実整数係数 を用いてより一般化して定義できる。 ここで β は、適合率と比較して再現率を何倍重視するかを表す係数である[2]。

第一種過誤と第二種過誤に関しては、これは次のようになる。

- 。

特に再現率をより重視する目的で β=2、適合率をより重視する目的で β=0.5 としたものがよく使われる。

Van Rijsbergenの有効性尺度に基づいている。

- 。

ただし、

調和平均としての記述 編集

応用 編集

F値は、情報検索の分野で、検索、文書分類、クエリ分類の性能を測定するためよく使われる。初期の研究では主に F1 Score に注目していたが、大規模な検索エンジンの普及に伴い、パフォーマンスの目標が適合度 precision や再現率 recall のいずれかに重点を置くようになったため、 が広く使われるようになった[3]。

F値は機械学習でも使用される[4]。しかし、F値は真陰性を考慮しないため、バイナリ分類器の性能を評価するには、マシューズ相関係数、インフォームドネス、コーエンのカッパなどの尺度が好ましいかもしれない[5]。

批判 編集

デビッド・ハンド氏らは、F1 Scoreは精度と再現率を同等に重視していることから批判している。実際には、誤分類の種類が異なれば、コストも異なる。適合率と再現率の相対的な重要性が問題となる[7]。

Davide Chicco と Giuseppe Jurman によると、F1 Scoreは、バイナリ評価分類のマシューズ相関係数よりも真実性と情報量が少ないとのこと[8]。

David Powersは、F1 Scoreが真陰性を無視するため、不均衡なクラスでは誤解を招くとを指摘している。

Fowlkes–Mallows インデックスとの違い 編集

多クラス分類への拡張 編集

F値は、3つ以上のクラスの分類問題(多クラス分類)の評価にも用いられる。この設定では、最終的なスコアは、ミクロ平均(クラスの頻度によるバイアスがある)またはマクロ平均(すべてのクラスを同等に重要視する)によって得られる。マクロ平均では、2つの異なる計算式が使用される。すなわち、クラスごとの適合率と再現率の平均に基づくF値、ないしクラスごとのF値の平均ある。後者の方がより望ましい特性を示す[10]。

関連項目 編集

脚注 編集

出典 編集

- ^ Sasaki, Y.. “The truth of the F-measure”

- ^ Van Rijsbergen, C. J. (1979). Information Retrieval (2nd ed.). Butterworth-Heinemann

- ^ X. Li; Y.-Y. Wang; A. Acero (July 2008). Learning query intent from regularized click graphs. doi:10.1145/1390334.1390393。

- ^ See, e.g., the evaluation of the .

- ^ Powers, David M. W. "What the F-measure doesn't measure". arXiv:1503.06410 [cs.IR]。

- ^ Derczynski, L. (2016). Complementarity, F-score, and NLP Evaluation.

- ^ Hand, David (英語). A note on using the F-measure for evaluating record linkage algorithms - Dimensions. doi:10.1007/s11222-017-9746-6 2018年12月8日閲覧。.

- ^ “The advantages of the Matthews correlation coefficient (MCC) over F1 score and accuracy in binary classification evaluation”. BMC Genomics 21 (6): 6. (January 2020). doi:10.1186/s12864-019-6413-7. PMC 6941312. PMID 31898477.

- ^ “Classification assessment methods”. Applied Computing and Informatics (ahead-of-print). (August 2018). doi:10.1016/j.aci.2018.08.003.

- ^ J. Opitz; S. Burst. "Macro F1 and Macro F1". arXiv:1911.03347 [stat.ML]。